Hippocratic AI, en av de mest lovende aktørene innen helse-KI, har nylig sikret seg 141 millioner dollar i ny finansiering, noe som understreker den raske veksten i sektoren. Med en verdivurdering på 1,64 milliarder dollar planlegger selskapet nå å ekspandere til nye markeder i EMEA, Sørøst-Asia og Latin-Amerika. Men denne globale ambisjonen reiser spørsmål: Hvordan ivaretar et selskap fra Silicon Valley kulturelle og etiske normer i helsesystemer som er radikalt forskjellige fra det amerikanske?

Hippocratic AIs ambisjoner utenfor USA

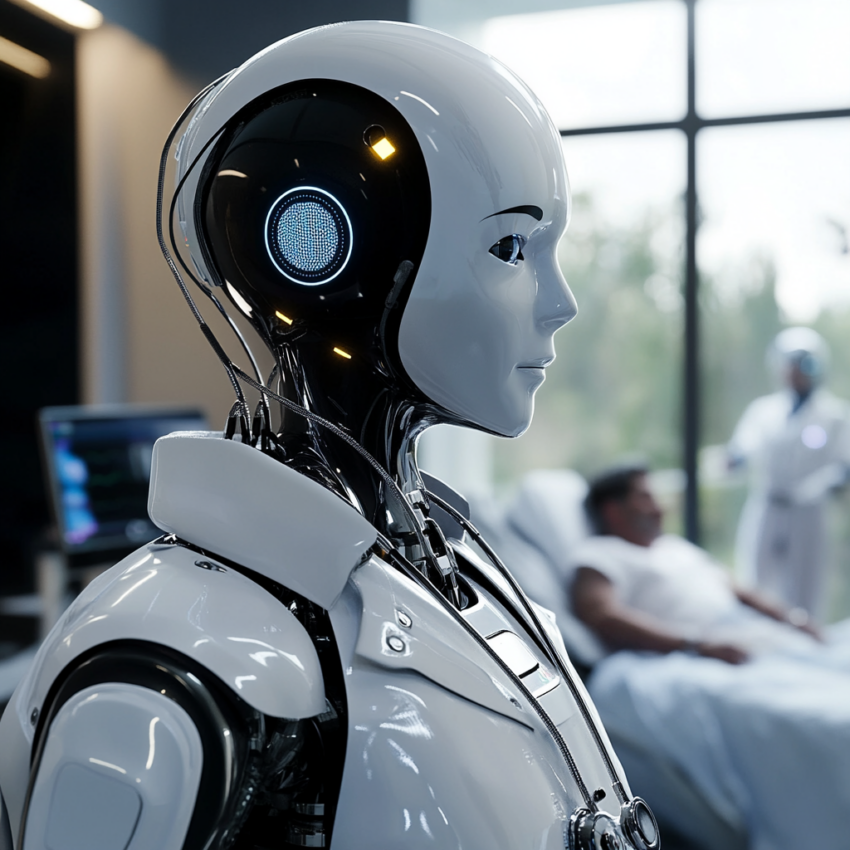

Hippocratic AI har allerede gjort seg bemerket i USA med KI-verktøy som håndterer ikke-diagnostiske oppgaver, som pasientoppfølging og forberedelse til operasjoner. Nå vil selskapet ta denne teknologien globalt, med mål om å løse arbeidskraftmangel og effektivisere helsetjenester i regioner med begrensede ressurser. Men ekspansjonen er ikke uten utfordringer.

Kulturell tilpasning eller teknologisk kolonialisme?

En av de største risikoene ved global ekspansjon av vestlig utviklet KI er manglende tilpasning til lokale normer. Hippocratic AI hevder at deres «Healthcare AI Agent App Store» lar klinikere tilpasse verktøyene til lokale behov. Likevel er spørsmålet om kulturell følsomhet sentralt:

- Hvordan håndterer en KI-agent skapt i USA tabuer eller helsevaner i Sørøst-Asia?

- Kan en algoritme lære å respektere tradisjonelle behandlingsmetoder i Latin-Amerika?

Uten grundig samarbeid med lokale helsearbeidere risikerer KI-verktøy å bli oppfattet som en påtvungen løsning – ikke en hjelpende hånd.

Fare for utnyttelse av svake helsesystemer

Mange land i Hippocratic AIs målmarkeder har underfinansierte helsesystemer og begrenset regulering av KI. Dette skaper et etisk dilemma:

- Brukes KI for å styrke lokale tjenester, eller blir den en billig erstatning for mangel på helsepersonell?

- Hvordan unngår selskapet å utnytte manglende lovverk til å teste eksperimentell teknologi på sårbare befolkninger?

Hippocratic AI understreker at deres verktøy kun skal brukes til ikke-diagnostiske oppgaver, men kritikere frykter at slike systemer kan bli et påskudd for å redusere investeringer i helsepersonell.

Standardisering vs. lokale behov

Hippocratic AIs «App Store»-modell, der klinikere kan tilpasse KI-agenter, høres demokratisk ut. Men i praksis krever dette at lokale helsearbeidere har kompetanse og tid til å redigere teknologien. Spørsmålet er om denne modellen:

- Fremmer lik tilgang til KI-verktøy på tvers av økonomiske forskjeller.

- Eller skaper den et hierarki der velstående sykehus får bedre verktøy enn ressurssvake klinikker.

Balansen mellom innovasjon og etikk

Hippocratic AI har satt «pasientsikkerhet» høyt på agendaen, inkludert streng testing av KI-agentene sine. Men i globale markeder må også etiske garantier strekke seg lenger:

- Hvordan sikrer selskapet at pasientdata fra utviklingsland ikke misbrukes?

- Hva gjør de for å forhindre at KI-forhåndsdommer (bias) forsterker ulikheter i helsetilgang?

Disse spørsmålene er avgjørende for om Hippocratic AIs teknologi blir mottatt som en løsning – eller en ny utfordring.

Mine tanker:

Hippocratic AIs globale ekspansjon viser potensialet for KI til å revolusjonere helsevesenet verden over. Men suksessen avhenger av hvordan selskapet håndterer de etiske fallgruvene ved å introdusere vestlig teknologi i nye kulturelle kontekster. For å unngå teknologisk kolonialisme må innovasjonen følges av ydmykhet, samarbeid og en ærlig diskusjon om hvem som egentlig tjener på KI-revolusjonen.